人工神经网络是模拟人脑神经活动的重要模式识别工具,备受关注。近年来,深度神经网络(Deep Neural Networks,DNN)的改进与优化工作集中于网络结构和损失函数的设计,而神经元模型的发展有限。神经生物学和认知神经科学的研究表明,神经元的学习能力是生物神经系统完成学习任务和记忆任务的重要基础。这些机理可促使科学家在神经元设计和优化方面进一步提高DNN的性能。

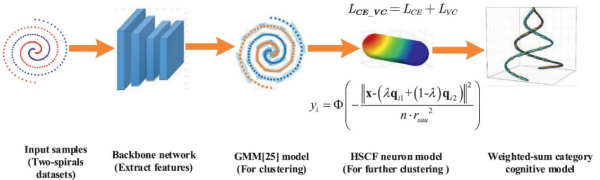

受生物认知机制的启发,中国科学院半导体研究所高速电路与神经网络实验室研究员李卫军团队,设计了具有高度柔性与可塑性的超香肠覆盖式神经元模型(HSCF neuron)(图1)。该研究定义了新的交叉熵和体积覆盖率损失函数。该损失函数可最大限度地压缩超香肠的体积,从而确保样本的类内紧凑性。该团队引入了一种分裂迭代方法,即将每个神经元模型视为一个弱分类器,并迭代增加弱分类器的数量。这一迭代方法可自适应地确定HSCF神经元的最优数量,形成了端到端的学习框架(图2)。该研究在模式识别领域的八个经典数据集上进行的对比实验和消融实验证明了这一方法的有效性。超香肠覆盖式神经元模型可应用于经典的DNN中以解决多种模式识别问题,颇具应用价值与学术价值。此外,该研究提出的方法证明了利用神经元可塑性增强DNN性能的可行性,为DNN的进一步发展提供了新视角。

近日,相关研究成果以Hyper-sausage coverage function neuron model and learning algorithm for image classification为题,发表在Pattern Recognition上,并入选期刊2023年Editors' Choice Paper。研究工作得到国家自然科学基金的支持。

图1. 超香肠覆盖式神经元模型及分类策略可视化表示

图2. 基于超香肠覆盖式神经元模型的网络结构示意图

学习园地